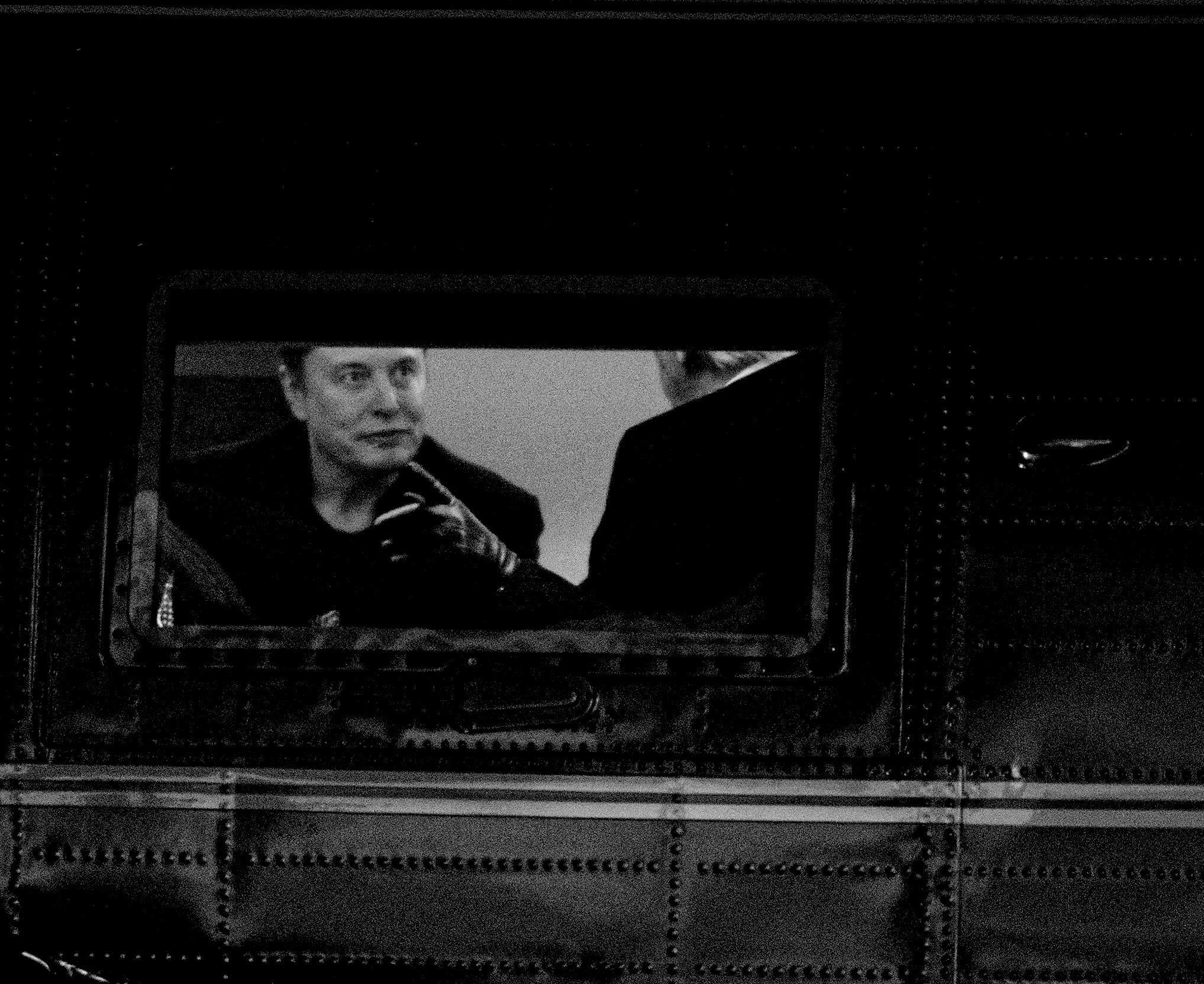

Depuis quelques semaines, Elon Musk met en scène sur X la prétendue « supériorité » de la nouvelle version de son nouveau modèle d’IA, Grok 3. Qu’en est-il réellement ?

S’il est vrai que Grok 3 se situe quasiment à la frontière de la technologie en matière d’IA, il n’a résolu aucun des problèmes fondamentaux qui affectent depuis longtemps les modèles de langage (LLM) : les hallucinations, les inexactitudes et une manière de raisonner à laquelle personne ne voudrait se fier.

C’est un problème de fond : si l’on rapporte à ces défauts inhérents ce que coûte Grok — à la fois en dollars mais aussi en dommages causés à l’environnement pour faire tourner ce modèle — cela devrait être un signal d’alarme.

Est-ce une pure opération marketing au service du projet Musk ?

Pas uniquement. Mais selon moi, c’est un exemple de plus, s’il en fallait, que les LLM ne sont tout simplement pas la voie royale vers ce que tous les investisseurs et les promoteurs de l’IA aujourd’hui, y compris Musk, veulent atteindre : l’intelligence artificielle générale.

Or l’idée même que l’on pourrait accéder à l’intelligence artificielle générale uniquement par un effet d’échelle en augmentant la taille des modèles me semble tout simplement erronée.

Tant qu’il existera un consensus sur le fait que les LLM sont la seule approche pertinente, la loi d’échelle dominera et aucun pays ne pourra réellement « gagner » la course à l’IA.

Gary Marcus

Avec des paris et des stratégies assez différents, xAI — l’entreprise de Musk ayant produit Grok — et le chinois DeepSeek semblent tous deux avoir atteint la frontière technologique assez rapidement — rattrapant les modèles connus de laboratoires établis tels que ceux d’Open AI ou d’Anthropic. Quelles leçons en tirez-vous pour la course à l’IA et la structuration du marché ?

La conséquence la plus immédiate est très claire : ces nouveaux modèles ont déclenché une guerre des prix.

Ces IA ne sont pas forcément meilleures que les autres. Il n’y a pas de rupture technologique majeure. En revanche, elles sont moins chères à construire.

C’est ce facteur qui a bouleversé toute l’économie du secteur et rendu encore plus improbable l’amortissement des coûts immenses des entreprises d’IA générative. Cette guerre des prix réduira les marges bénéficiaires à presque zéro.

L’autre conséquence est politique : il est désormais clair que les États-Unis ne sont plus les seuls acteurs. Or tant qu’il existera un consensus sur le fait que les LLM sont la seule approche pertinente, la loi d’échelle dominera et aucun pays ne pourra réellement « gagner » la course à l’IA. Comme sur une autoroute, nous continuerons simplement à nous doubler les uns les autres à tour de rôle — à moins qu’une nouvelle technologie ne soit inventée.

Dario Amodei, le fondateur d’Anthropic considère que l’on pourrait atteindre l’intelligence artificielle générale 2026-2027 — au sens d’un modèle capable de fonctionner au niveau d’un docteur ou d’un lauréat du prix Nobel. Demis Hassabis, le fondateur de DeepMind, présente quant à lui un calendrier beaucoup plus conservateur. Selon vous, les développements récents viennent-ils remettre en question ces projections ou les soutenir ?

Les prédictions de Dario me semblent totalement irréalistes.

En 2022, j’avais fait face à beaucoup d’hostilité de la part de la communauté de l’IA pour avoir soutenu que les lois d’échelle n’étaient pas vraiment des lois et qu’un tel raisonnement ne pourrait pas tenir indéfiniment. À cet égard, il me semble que les découvertes récentes soutiennent plutôt mes conjectures initiales.

J’irais même plus loin : je serais vraiment étonné si nous atteignions l’intelligence artificielle générale dans les trois prochaines années — et franchement surpris si nous la voyions émerger au cours de cette décennie.

Si nous voulons y parvenir, je pense qu’il nous faudrait repenser notre approche de fond en comble : les LLM n’y parviendront probablement pas par eux-mêmes.

Musk se fiche totalement de la liberté d’expression.

Gary Marcus

Elon Musk a affirmé que Grok 3 était « un système d’IA à la recherche maximale de la vérité » même si cette vérité peut entrer en conflit avec le « politiquement correct ». Sa position reflète les remarques du vice-président américain, J. D. Vance, lors de la Conférence sur la sécurité de Munich ou lors d’une récente conférence de presse avec Keir Starmer, dans laquelle il a à nouveau accusé les dirigeants européens de « supprimer la liberté d’expression ». Comment ces discours convergents s’inscrivent-ils dans le projet des techno-césaristes autour de Trump ?

Musk se fiche totalement de la liberté d’expression.

Ce qui l’intéresse, c’est de construire une infrastructure qui lui soit favorable. Il veut être le seul à pouvoir dire ce qu’il veut — peu importe que ce soit vrai ou pas.

Vous avez décrit Grok 3 comme une forme « d’automatisation du Ministère de la Vérité » orwellien. Pensez-vous que les LLM pourront influencer nos comportements dans un avenir proche.

Oui, et pas seulement à la marge. Les recherches de Mor Naaman à Cornell ont montré non seulement que les LLM peuvent influencer nos croyances, mais qu’ils peuvent le faire de manière si subtile que nous ne nous en rendons même pas compte.

La logique de persuasion par l’IA est insidieuse.

Il y a tout lieu de craindre que les acteurs politiques en profitent de plus en plus — au détriment considérable des démocraties.

Comment le discours sur la liberté d’expression, porté notamment par Musk et Vance, influence-t-il le développement des générations actuelles et futures de modèles d’IA ?

Il le fait d’une manière très pernicieuse. La qualité des modèles, du moins à l’heure actuelle, repose sur les données. Or l’arsenalisation orwellienne portée par Musk sur la liberté d’expression conduit en réalité à appauvrir la qualité des données qui nourrissent les modèles d’IA. L’accent mis sur la « liberté d’expression » ne conduit donc pas à de meilleurs modèles — juste à plus de totalitarisme.

L’extrême droite a réussi un tour de force : disqualifier la vérité en tant que critère pertinent pour juger de la qualité d’un modèle d’IA. Dans un tel environnement, on voit mal comment la démocratie pourrait continuer à fonctionner.

À Paris, en capitulant devant les oligarques de la technologie, Macron a finalement vendu la démocratie au rabais.

L’arsenalisation orwellienne portée par Musk sur la liberté d’expression conduit en réalité à appauvrir la qualité des données qui nourrissent les modèles d’IA.

Gary Marcus

Ne pensez-vous pas au contraire que le paysage géopolitique actuel en pleine mutation pourrait permettre à l’Europe trouver l’occasion d’une bifurcation dans la course à l’IA ?

L’Europe ne disposait en propre que d’un seul outil : réglementer l’IA pour ne pas en faire un désastre pour les consommateurs.

Elle est sur le point d’y renoncer.

Les Européens ont cédé tellement de terrain à la Silicon Valley que je ne vois pas comment ils peuvent rattraper leur retard.

J’ajouterais qu’en accordant autant de pouvoir à ces entreprises sur la base de la promesse très probablement erronée que les futurs modèles nous permettront comme magiquement d’atteindre l’intelligence artificielle générale — même si l’on sait que les modèles actuels sont imparfaits — l’Europe s’est infligée à elle-même beaucoup de tort.

Si elle avait énoncé d’emblée : « nous n’entrerons pas dans ce petit jeu tant qu’il ne pourra pas être démontré objectivement que ces modèles sont justes et fiables », le monde serait peut-être meilleur aujourd’hui. En tout cas, il serait très différent.

Pensez-vous qu’elle puisse être un jour compétitive sur le développement de l’IA sans dépendre des États-Unis ou de la Chine pour accéder aux modèles de pointe ?

Dans la mesure où ces modèles sont pour l’essentiel disponibles dès maintenant, je dirais : peut-être. Mais au moment où les États-Unis réduisent leur financement dans la science et que la Chine se précipite dans une course à l’américaine qui pourrait ne pas s’avérer si rentable pour elle, la seule façon pour l’Europe de gagner serait d’investir massivement dans une stratégie qui prenne à contre pied cette dynamique.

L’extrême droite a réussi un tour de force : disqualifier la vérité en tant que critère pertinent pour juger de la qualité d’un modèle d’IA.

Gary Marcus

Cela peut paraître contre-intuitif à première vue, mais ce n’est qu’en refusant de participer à cette course délirante que l’Europe aurait vraiment une chance de s’en sortir par le haut.