Dans la continuité du dialogue intellectuel entrepris par la revue avec l’UNESCO, après la leçon magistrale de Dipesh Chakrabarty l’an dernier, nous publions la première Conférence Albert Hirschman, lancée par Gabriela Ramos et le programme MOST, intitulée « Le progrès technologique peut-il faire naître une prospérité partagée ? », prononcée par le prix Nobel d’économie Daron Acemoğlu 2024 à Paris le 8 octobre.

English version available on the Groupe d’études géopolitiques website

Le progrès technologique peut-il faire naître une prospérité partagée ? Peut-être faudrait-il plutôt se demander : quand le progrès technologique peut-il faire naître une prospérité partagée. Pour tenter de répondre à cette question, je vais partir du dernier livre que nous avons écrit avec Simon Johnson, Power and Progress 1.

La raison pour laquelle nous sommes si obsédés par le progrès technologique n’est pas très difficile à comprendre. Une grande partie de l’humanité vit en meilleure santé et de manière plus prospère et confortable par rapport aux standards d’il y a 300 ans : être impressionné par ce que la technologie et l’innovation ont apporté ne demande pas beaucoup d’effort.

Mais nous allons montrer que cette image d’ensemble cache des variations beaucoup plus intéressantes et riches d’enseignements pour l’époque que nous vivons. Dans l’histoire de la prospérité apportée par le progrès technologique, peu de choses sont automatiques ou inévitables. Cela dépend essentiellement des institutions, du type de progrès technologique et de ceux qui le contrôlent.

Ces questions sont d’autant plus importantes alors que nous traversons ce que certains considèrent comme l’ère de l’innovation, où nous sommes entourés chaque jour de nouveaux produits d’intelligence artificielle, de nouvelles applications et de nouveaux gadgets. Selon la plupart des métriques qui permettent de prendre la mesure de l’innovation, comme les brevets, nous assistons de fait à une véritable explosion — en témoignent les données relatives aux dépôts de brevets aux États-Unis, qui ont été multipliés par quatre entre le début des années 1980 et aujourd’hui. De manière encore plus remarquable, cette augmentation a été portée par ce que beaucoup considèrent comme des secteurs fondamentaux, à l’instar de la communication, des technologies de l’information ou de l’électronique, sur lesquels reposent aujourd’hui de nombreuses autres activités économiques et, bien sûr, de l’IA — et notamment l’IA générative —, qui peuple les imaginaires des deux côtés de l’Atlantique.

Il suffit de regarder les États-Unis pour mettre en perspective l’obsession européenne pour l’IA : outre-Atlantique, l’engouement pour ces questions a atteint un niveau bien plus élevé. À l’ère de l’innovation, des percées de l’IA et des avancées technologiques époustouflantes, des questions centrales occupent l’esprit de beaucoup de gens : qui bénéficiera de ces technologies ? S’accompagneront-elles d’une prospérité partagée ? Qui les contrôle réellement ?

Ces questions sont centrales en partie parce que, si l’on regarde l’histoire, des lignes très claires relient le contrôle des technologies à la façon dont les bénéfices sont distribués — et posent la question de savoir s’il apporte ou non des bénéfices. Ces problématiques devraient avoir la plus grande centralité dans le débat public et en économie.

Il existe cependant à leur égard en économie une sorte de « théorème de tout le monde » 2. Comme la plupart des théorèmes de tout le monde, il contient une part de vérité et beaucoup de simplifications ou de contre-vérités. Avec d’autres sources structurelles d’optimisme technologique, il a marqué la façon dont de nombreuses personnes, décideurs politiques, journalistes, faiseurs d’opinion dans le monde entier et aux États-Unis pensent au progrès technologique et à l’IA. Comme souvent avec les théorèmes qui font partie de la culture ou du folklore, il n’avait même pas de nom. Avec Simon Johnson, nous avons essayé de lui en donner un : le « productivity bandwagon ». Selon ce théorème, les progrès technologiques conduiraient d’une manière ou d’une autre, à travers un processus automatique, à une prospérité partagée.

Qu’est-ce que le productivity bandwagon ?

Si cette théorie est vraie, elle ne nous dispense pas de nous poser certaines questions sur qui contrôlera la technologie, et qui en profitera le plus — ou un peu moins. Elle nous dit, grosso modo, que nous ne devrions pas avoir peur de la technologie et que nous devrions l’accueillir à bras ouverts, car il y a de fortes chances pour qu’elle bénéficie à tous.

Qu’est-ce que le « productivity bandwagon » ? Les étudiants de la Sorbonne l’apprennent encore dans leur cours de licence ou de master : lorsque la technologie s’améliore, nos connaissances et notre capacité à faire des choses s’améliorent aussi.

Si on l’applique au processus de production, cela signifie que lorsque la productivité augmente, nous pouvons obtenir plus de production et plus de biens et de services à partir des mêmes intrants car nous disposons de meilleures capacités, de meilleures connaissances et d’une meilleure technologie. À partir de là, un ensemble de forces conduisent à des améliorations pour les travailleurs également — en termes de salaires plus élevés et de gain potentiel Il s’agit là d’un aspect clef dans la mesure où la plupart d’entre nous tire encore l’essentiel de leurs revenus du marché du travail — si celui-ci est dynamique, les salaires sont élevés. Il s’agit là d’une base solide pour une prospérité partagée.

Comment expliquer ce lien entre l’augmentation de la productivité et les avantages pour les travailleurs ? On pourrait par ailleurs se demander si, lorsque la technologie s’améliore, la productivité augmente également — car il existe des cas où l’amélioration des connaissances est utilisée à d’autres fins que l’augmentation de la productivité. Mais laissons cette question de côté pour nous concentrer sur l’essentiel : la productivité augmente, et les travailleurs en profitent.

L’argument économique de base est le suivant : lorsque les entreprises ont les moyens de produire davantage, elles veulent se développer et embaucher plus de main-d’œuvre pour pouvoir produire davantage. Cette dynamique augmente la demande de main-d’œuvre, et les processus du marché du travail conduisent à des salaires plus élevés.

Cet argument contient en réalité deux affirmations : d’une part, si la productivité augmente, les entreprises voudront embaucher plus de main-d’œuvre ; d’autre part, cette demande de main-d’œuvre se traduit d’une manière ou d’une autre par des salaires plus élevés.

Ces deux affirmations ne sont pas déraisonnables. On trouve de nombreux exemples, y compris au cours du XXe siècle, où elles fonctionnent toutes deux : l’augmentation de la productivité entraîne d’une manière ou d’une autre une plus forte demande de main-d’œuvre, celle-ci se traduisant par des salaires plus élevés.

Pour autant, nous pourrions également trouver des exemples qui contredisent chacune de ces affirmations.

C’est ce que nous allons essayer de développer et d’expliquer, en essayant de comprendre quand est-ce que le mécanisme de prospérité partagée fonctionne.

Commençons par la seconde hypothèse — l’idée qu’une plus forte demande de main-d’œuvre n’entraîne pas des salaires plus élevés. Deux exemples permettent de l’illustrer — bien qu’on puisse en imaginer d’autres, peut-être d’ailleurs aussi significatifs pour leur époque que les avancées technologiques numériques que nous connaissons aujourd’hui.

Le pouvoir joue un rôle crucial dans la manière dont les gains sont distribués et dans la réussite de cette étape pour la productivité.

Daron Acemoğlu

Tout d’abord, le Moyen-Âge, qu’on a volontiers qualifié « d’âge sombre », ne l’a pas été tant que cela au plan technique : en témoignent les avancées impressionnantes dans le domaine agricole. Les moulins à vent ont ainsi modifié le processus de production de manière considérable, multipliant la productivité de certaines tâches par plus de dix, voire vingt. Quel en fut l’effet ? La noblesse et le haut clergé retirèrent tous les bénéfices et la vie des paysans ne s’en trouva guère améliorée. Lorsqu’on y réfléchit, c’est assez logique : les paysans étaient soumis à une relation coercitive dans le cadre du servage et par le biais des taxes qu’ils devaient payer aux propriétaires terriens. Plus important encore, ces mêmes propriétaires terriens avaient le monopole complet des moulins à vent, si bien qu’ils étaient non seulement en mesure d’empêcher quiconque d’ouvrir son propre moulin, mais même d’obliger les gens à utiliser le leur. Dans de telles conditions, le type de processus concurrentiel sur le marché du travail qui serait nécessaire pour qu’une augmentation de la demande de main-d’œuvre se traduise par une augmentation des salaires ne peut pas fonctionner.

Le deuxième exemple est encore plus frappant : la machine à égrener le coton conçue par Eli Whitney (cotton gin). Au mitan des années 1700, le Sud de ce qui allait devenir les États-Unis était une région économiquement défavorisée, déjà en retard par rapport à de nombreuses autres régions du pays. Le climat y était favorable et la main-d’œuvre suffisante pour développer certaines cultures très rentables — comme le coton. Mais le coton cultivé dans le Sud ne pouvait pas être nettoyé selon la méthode habituelle, nécessitant l’émergence d’une machine que l’on essaya pendant un certain temps de mettre au point.

Quelques prototypes finirent par voir le jour, dont celui breveté par Eli Whitney. Les contemporains et les historiens s’accordent à dire que la machine de Whitney a totalement transformé le Sud des États-Unis, entraînant une augmentation considérable de la production de coton. De fait, les États-Unis devinrent le plus grand exportateur de coton au monde, jouant un rôle moteur de la révolution industrielle avec l’industrie textile britannique. De nombreuses fortunes gigantesques se bâtirent grâce à cette augmentation massive des exportations. Pour autant, les travailleurs furent complètement exclus de ce mouvement car il s’agissait de Noirs américains réduits en esclavage qui n’avaient pas la possibilité d’exiger des salaires plus élevés sur des marchés du travail concurrentiels. Lorsque les propriétaires terriens voulaient obtenir plus de travail de leur part, ils se contentaient d’avoir recours à la coercition. Un grand nombre d’esclaves furent déplacés vers le Sud, où se trouvaient les plantations de coton, et leurs conditions de vie se détériorèrent même pour la majorité d’entre eux.

Ces deux exemples illustrent l’importance de l’environnement institutionnel ou, pour le dire plus clairement, le rôle du pouvoir. C’est de là que vient le mot « pouvoir » (power) dans Power and Progress, le titre de notre livre.

Le pouvoir joue un rôle crucial dans la manière dont les gains sont distribués et dans la réussite de cette étape pour la productivité. Il a des canaux institutionnels — mais pas uniquement. Le pouvoir joue également un rôle essentiel dans l’orientation de l’innovation.

Révolution industrielle et automatisation

Ces exemples historiques sont-ils vraiment pertinents à l’ère numérique ?

En disant que nous vivons dans de bien meilleures conditions qu’il y a 300 ans, il n’y a en effet pas besoin de remonter à l’époque des moulins à vent — mais plutôt au début de la révolution industrielle britannique, aux alentours de 1750, lorsque des technologies beaucoup plus avancées commencèrent à être utilisées dans les usines.

Une manière simpliste de résumer la révolution industrielle britannique consisterait à dire que tout le monde en a profité — y compris les travailleurs — et qu’il n’y aurait, partant, rien à craindre de la technologie. Mais un examen plus précis de cette histoire dessine un tableau plus complexe. Tout d’abord, pendant la majeure partie de cette période — soit environ cent ans — les travailleurs n’étaient pas très bien lotis. Et cela a précisément à voir avec ce que nous évoquions plus haut : le pouvoir.

Bien souvent, ces derniers n’avaient pas d’options : les syndicats étant persécutés, ils ne pouvaient pas être représentés ; la négociation collective n’était donc pas possible ; les lois étaient très hostiles aux travailleurs. On envoyait par exemple des personnes en prison uniquement pour avoir quitté leur employeur et cherché un meilleur travail.

Mais il y a quelque chose d’encore, de plus profond, qui a trait à la nature même de la technologie.

Les premières technologies de la révolution industrielle correspondent à ce que nous appellerions aujourd’hui l’automatisation — c’est-à-dire la création de machines et d’algorithmes pour réaliser des tâches auparavant effectuées par des travailleurs.

Ce que montre les exemples que nous avons listés, c’est que ce type d’automatisation n’a pas nécessairement eu pour effet de libérer les forces du productivity bandwagon. Cela n’est pas vraiment surprenant : l’hypothèse, que nous évoquions plus haut, selon laquelle les gains de productivité incitent à plus d’embauches de travailleurs, n’a en soi rien d’incontestable.

Les entreprises seraient prêtes à payer pour les travailleurs, apprend-t-on en économie. Le nombre de travailleurs qu’elles seraient susceptibles d’embaucher serait lié à la contribution du travail à la production — ce que les économistes appellent la productivité marginale. En revanche, lorsque nous disons que la productivité augmente, nous parlons de la quantité produite par rapport à la quantité de travail — ce qui correspond à la productivité moyenne. Il y a des raisons de penser que la productivité moyenne et la productivité marginale évoluent de concert : l’une augmente, l’autre aussi. Mais il y a aussi bien des raisons de penser que ce n’est pas le cas.

Une plaisanterie nous aide à capturer l’essence de cette question, c’est-à-dire une vision utopique ou dystopique de l’avenir : l’usine du futur aura deux employés — un homme et un chien. L’homme est là pour nourrir le chien. Le chien est là pour s’assurer que l’homme ne touche pas aux machines.

Cela peut-être une idée de l’utopie. Mais ce n’est pas exactement une bonne nouvelle pour le travail en général. L’essence de cette plaisanterie, c’est que le productivity bandwagon ne fonctionne pas : on peut augmenter sa productivité en faisant en sorte que son usine ressemble de plus en plus à celle que l’on vient de décrire. Les machines de cette usine s’améliorent. Elle peut produire désormais deux fois plus. Mais on n’a besoin ni de l’homme ni du chien — ils sont tout à fait superflus.

Si la productivité est multipliée par deux, aucune usine ne s’empressera d’embaucher davantage d’hommes et de chiens.

Ce que cet exemple illustre en substance, c’est que la machine élimine le besoin de travailleurs et creuse un fossé entre la productivité marginale et la productivité moyenne. Et c’est précisément ce qui s’est passé dans la première moitié de la révolution industrielle britannique — une période qui a probablement duré entre 90 et 100 ans.

Ce n’est qu’à la fin des années 1840 qu’on a commencé à observer des augmentations de salaire régulières et une amélioration des conditions de travail, ce qui correspond — et ce n’est pas une coïncidence — avec la reconnaissance des syndicats. Il s’agit d’une histoire à la fois technologique et institutionnelle.

On ne s’intéresse peut-être pas à cette histoire parce qu’on pense qu’elle appartient au passé ; certains gourous de la technologie ont peut-être utilisé la révolution industrielle pour justifier leurs théories — on peut désormais les oublier, nous vivons à une époque différente.

Les temps que nous vivons sont-ils vraiment si différents ? Oui et non. Il existe en effet des similitudes et des distinctions notables, qui sont particulièrement visibles dans les années 1950, 60 et 70 aux États-Unis, en France, en Allemagne et dans de nombreux autres pays.

On peut examiner les données aux États-Unis en regardant les salaires corrigés de l’inflation pour les hommes et les femmes, et pour cinq groupes d’éducation, allant des travailleurs ayant abandonné les études secondaires jusqu’à ceux ayant un diplôme d’études supérieures.

Les données utilisées dans les graphiques ci-dessus sont normalisées à zéro afin de pouvoir suivre l’augmentation cumulative des salaires réels. On constate qu’à partir de 1963 — date à laquelle la série de données commence — et jusqu’au milieu et à la fin des années 1970, on assiste à une période remarquable de prospérité partagée. Les dix groupes démographiques connaissent tous une augmentation des revenus réels et une croissance relativement rapide.

Si nous prolongions cette série de données avec d’autres sources en remontant jusqu’aux années 1940, nous constaterions une croissance encore plus rapide pour les groupes démographiques les moins diplômés. Il s’agit d’une période de croissance relativement égalitaire, où le bas de la distribution des salaires croît très rapidement. La croissance moyenne entre 1949 et 1975 aux États-Unis est d’environ deux points et demi de pourcentage par an, corrigée de l’inflation, ce qui signifie que les revenus réels ont de fait doublé en 30 ans. Avec une telle croissance, il est assez facile d’accéder à la classe moyenne.

Il s’agit d’une expérience de prospérité partagée que de nombreux pays, en particulier en Occident, ont connue. En France, ces trois décennies ont été « glorieuses », mais elles l’ont été aussi ailleurs dans le monde. Vers 1980, peut-être un peu plus tôt, on commence à observer une trajectoire très différente : une divergence notable entre le haut et le bas de l’échelle. La raison pour laquelle on peut s’intéresser aux données cumulatives est qu’elles permettent de constater que les revenus réels des diplômés du secondaire et de ceux ayant abandonné les études diminuent au cours de cette période. Pendant une trentaine d’années, une grande partie de la population, loin de bénéficier de la croissance économique, a vu ses revenus réels, corrigés de l’inflation, diminuer. Il existe des similitudes dans d’autres pays, notamment au Royaume-Uni où des inégalités marquées coïncident avec des changements technologiques disruptifs et sociaux rapides.

Mais cette trajectoire n’est pas la même partout.

Si l’on regarde ce qui se passe en Suède sur la même période — ou du moins sur la seconde moitié de cette période —, l’inégalité salariale tend en fait à diminuer. La Suède est exposée aux mêmes technologies et à la même mondialisation, mais le tableau est beaucoup plus complexe. L’inégalité salariale diminue alors même que l’inégalité globale augmente, en partie à cause de l’évolution des heures de travail, des revenus du capital et d’autres facteurs qui peuvent ou non être affectés par la mondialisation.

L’idée sur laquelle on souhaite insister est qu’il existe des décisions différentes prises par les pays qui détermineront qui gagnera et qui perdra. Nous revenons donc revenus notre questionnement initial : comment assurer la prospérité ou la croissance partagée ? Comment se fait-il qu’aux États-Unis, en Europe et au Royaume-Uni, la croissance des revenus ait été relativement bien répartie durant les décennies qui ont suivi la Seconde Guerre mondiale ? Comment cela s’est-il manifesté pendant la seconde moitié du XIXe siècle, lors de la révolution industrielle britannique ? Et comment cela a-t-il été inversé dans les années 1980 ?

L’automatisation n’est pas un phénomène nouveau que l’on découvre avec les technologies numériques.

Daron Acemoğlu

Notre argument est lié aux deux piliers du mécanisme de prospérité partagée déjà soulignés. Premièrement, le pouvoir est réparti de manière égale entre les travailleurs et les entreprises — ou du moins pas de manière très inégale — afin d’éviter les situations que nous avons connues avec le servage en Europe au Moyen Âge ou avec l’esclavage dans le Sud des États-Unis. Ensuite, il y a une orientation de la technologie qui ne se contente pas d’automatiser, mais qui crée également de nouvelles possibilités technologiques pour augmenter la productivité du travail et la contribution du travail au processus productif. C’est ce qu’on observe, par exemple, dans l’industrie automobile aux États-Unis qui, dès les années 1910, a posé les bases des développements de l’après-guerre.

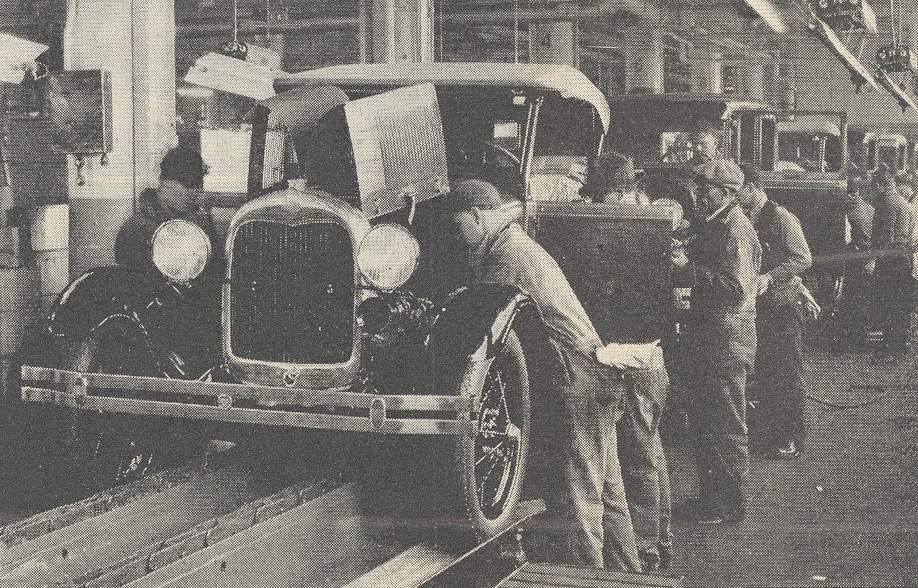

Henry Ford a été le pionnier des chaînes de montage, des machines électriques, d’une productivité élevée et de la production de masse. Dans son usine de River Rouge, dans le Michigan, il a mis en place une organisation « à plat » qui permettait de déplacer les voitures sur toute la surface. Des machines électriques décentralisées effectuaient des tâches qui, auparavant, ne pouvaient être réalisées que par des ouvriers.

L’automatisation n’est pas un phénomène nouveau que l’on découvre avec les technologies numériques. Ce que l’on constate dans l’usine Ford, c’est que l’automatisation a été associée à un grand nombre de nouvelles tâches techniques pour les travailleurs. Ceux que l’on peut apercevoir sur la photographie remplissent des fonctions essentielles quand d’autres, derrière, même plus nombreux, s’occupent des réparations, de l’entretien, de la comptabilité, de l’ingénierie et du travail de bureau. C’est pour cette raison que lorsque la production de masse a commencé, l’emploi dans les usines Ford et dans l’industrie automobile a explosé. L’automatisation a été associée à d’autres technologies qui ont créé de nouvelles tâches pour les travailleurs, de sorte que ces derniers ont été réaffectés à des activités plus techniques et mieux rémunérées à mesure que certaines des activités qu’ils effectuaient auparavant étaient prises en charge par les machines.

Cet équilibre entre les nouvelles tâches et l’automatisation est à la fois organisationnel et technologique : faut disposer des technologies nécessaires pour y parvenir — ce qui compte, donc, c’est l’orientation de la technologie et de l’organisation.

Henry Ford a pris cette décision non pas parce c’était un ami des travailleurs — loin de là — mais parce qu’il avait compris que l’augmentation de la productivité du travail était le meilleur moyen d’accroître ses propres résultats. Il n’était pas le seul. L’industrie automobile était également un foyer d’intense activité syndicale.

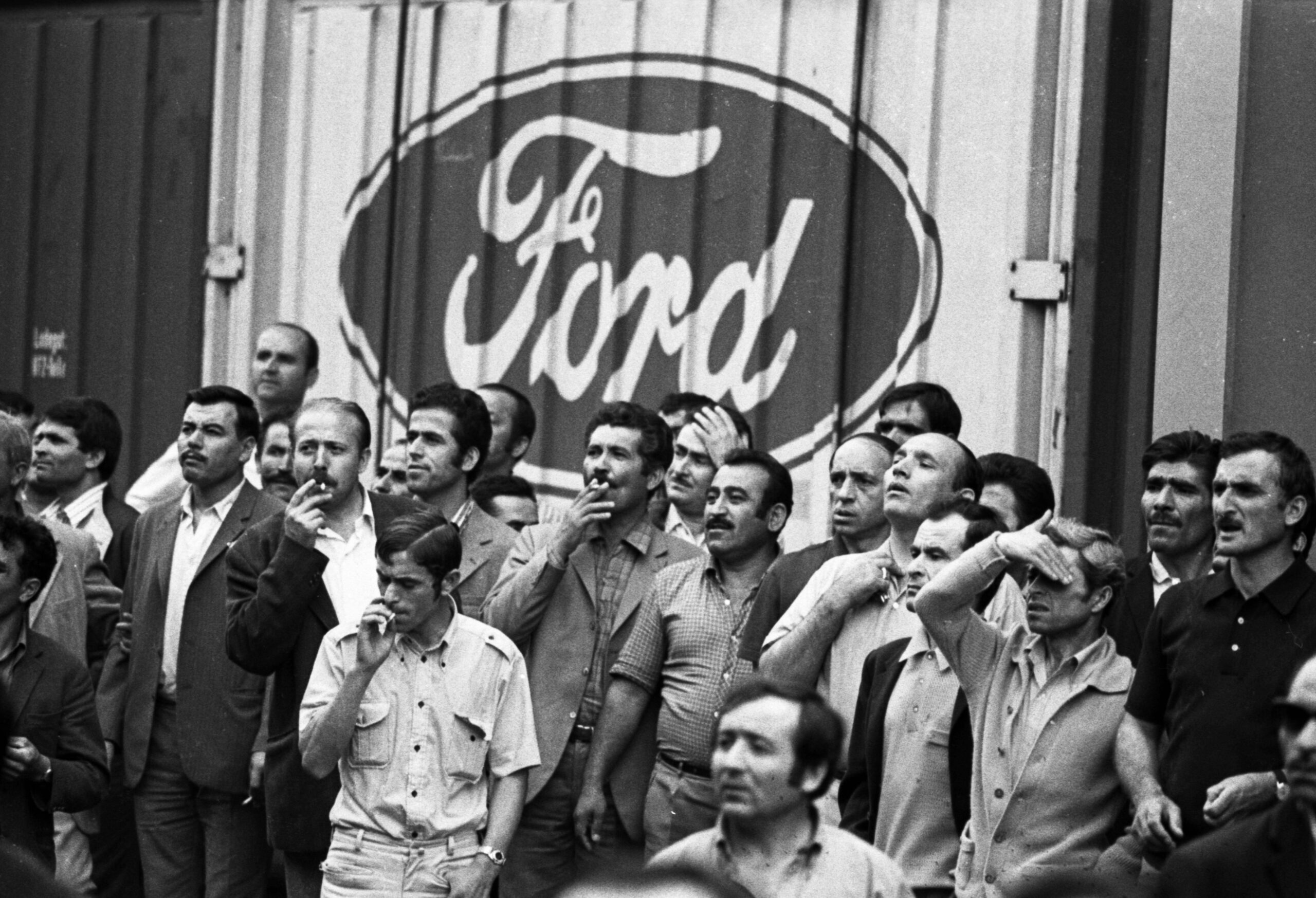

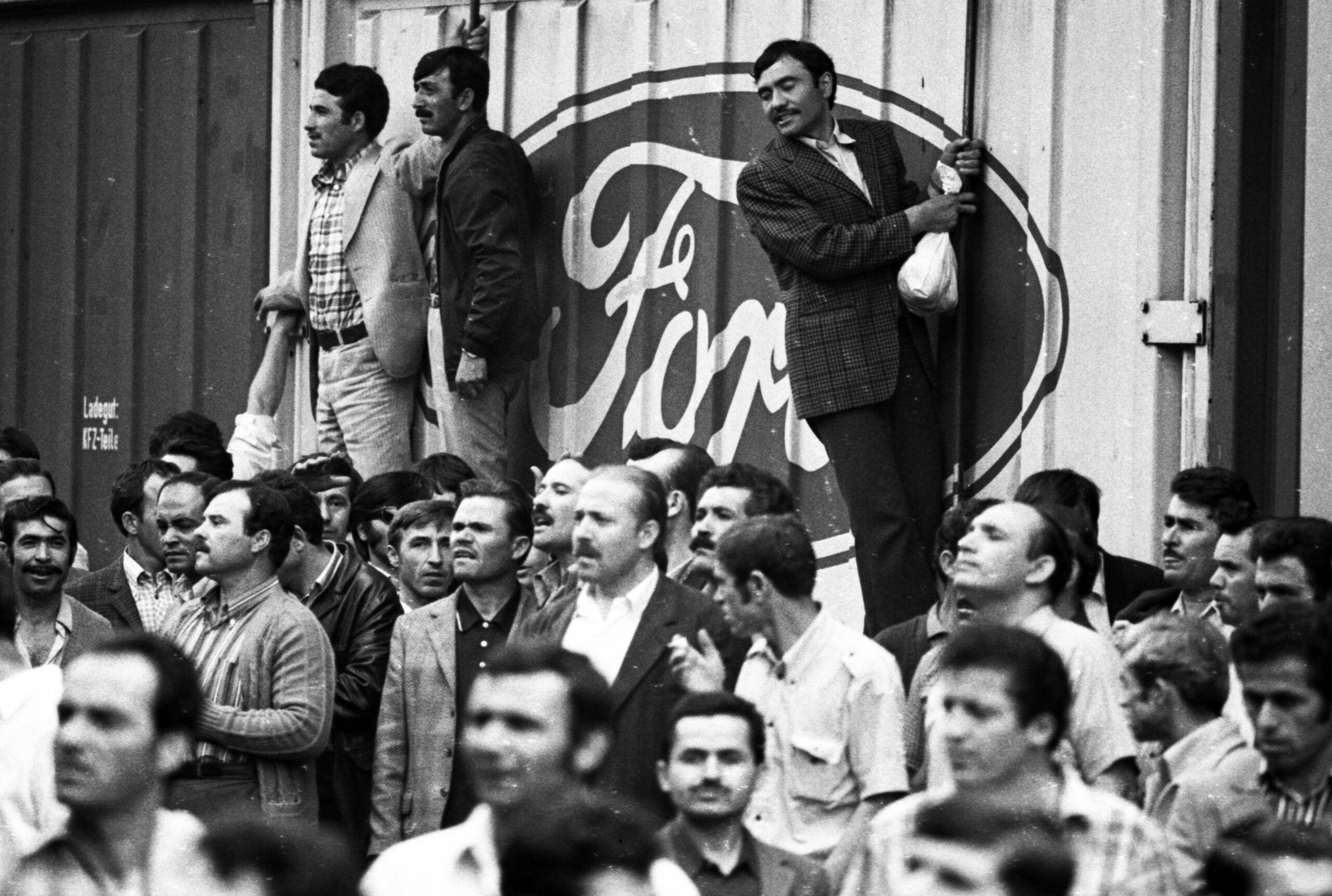

L’image ci-dessus montre la grève des travailleurs de l’automobile (United Auto Workers) dans une usine de General Motors, en 1937. Il y avait déjà eu des grèves dans les usines Ford. Le renforcement des syndicats a joué un rôle essentiel dans l’obtention par les travailleurs d’une part équitable des augmentations de productivité. De l’industrie automobile, dans les années qui ont suivi, les syndicats se sont étendus à d’autres secteurs.

Ces deux forces sont remarquablement similaires lorsqu’on examine la deuxième phase de la révolution industrielle britannique, qui a également vu un changement d’orientation de la technologie, passant de l’automatisation pure à des moyens d’augmenter la productivité du travail et d’équilibrer la distribution du pouvoir dans les usines et les sociétés.

S’il s’agit là des deux piliers de la prospérité partagée, on peut soutenir que c’est aussi leur défaite qui est à l’origine de l’augmentation considérable des inégalités et de la nature très peu partagée de la croissance économique aux États-Unis et dans de nombreux autres pays industrialisés au cours des quatre dernières décennies.

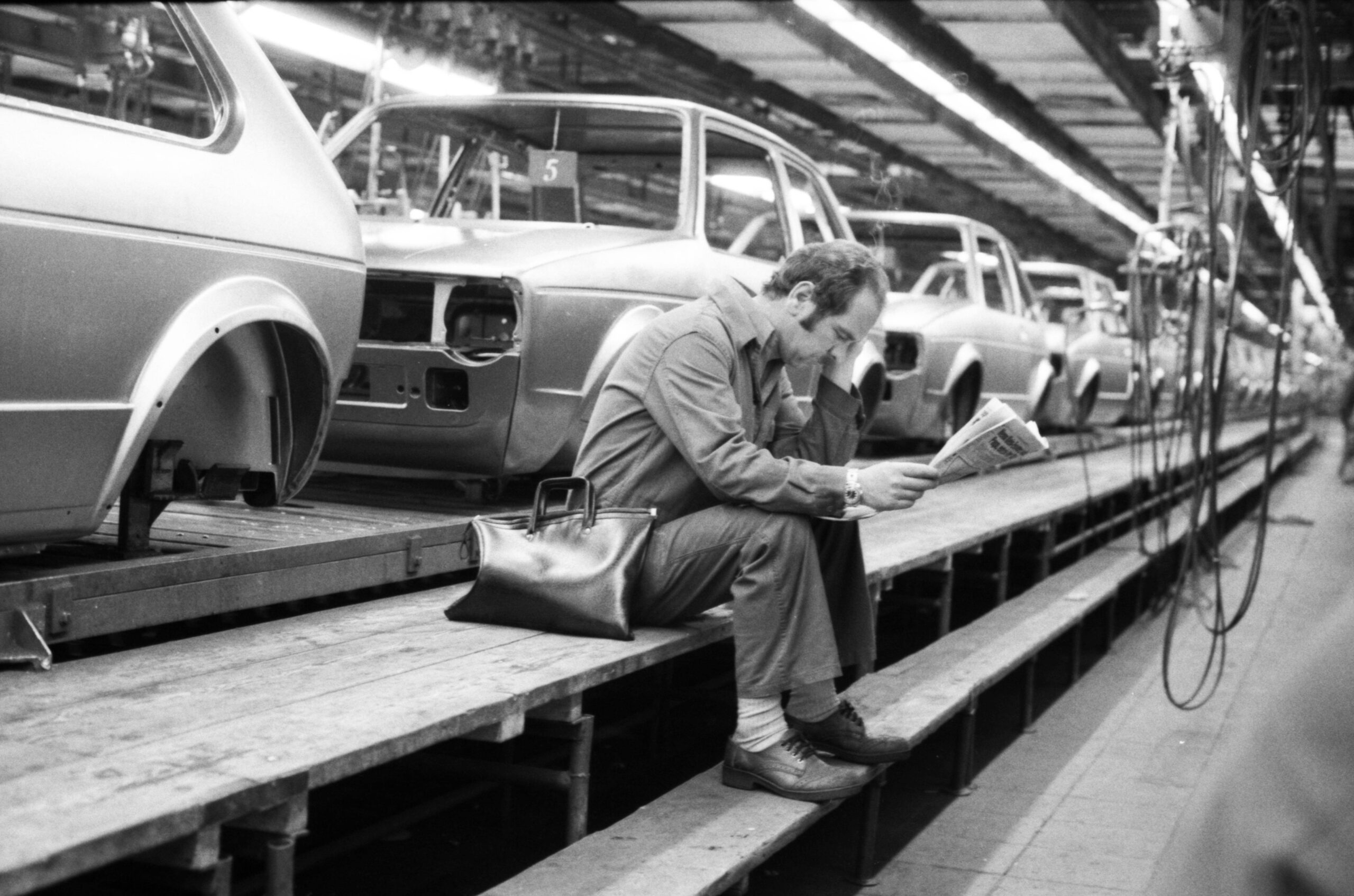

L’image ci-dessus montre à quoi ressemble une usine automobile aujourd’hui. L’automatisation a beaucoup progressé, mais on ne voit pas les ouvriers comme dans l’usine de Ford. Il n’y a qu’une seule personne, et elle a probablement un doctorat. En effet, alors que l’automatisation dans les usines automobiles a beaucoup progressé, le nombre de travailleurs manuels, qui assuraient la production, a considérablement diminué parce que les machines ont été ciblées sur l’automatisation, sans qu’il y ait eu de changements dans d’autres technologies créant de nouvelles tâches pour les ouvriers. Il ne s’agit peut-être pas d’un argument souvent avancé, car l’augmentation des inégalités aux États-Unis est fréquemment expliquée par d’autres facteurs potentiels.

La manière dont nous utilisons et développons la technologie et la manière dont nous nous organisons autour d’elle relèvent donc, en grande partie, d’une série de décisions. C’est dans cet enchevêtrement que la compréhension du fonctionnement des institutions et du pouvoir devient essentielle.

Daron Acemoğlu

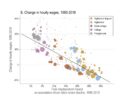

Pour souligner l’importance de l’automatisation, on peut présenter un autre ensemble de données, basé sur notre travail avec Pascual Restrepo, où nous examinons les changements de l’inégalité salariale aux États-Unis en les mettant en relation avec l’automatisation. Sur la figure ci-dessous, chaque point représente un certain groupe démographique. Plutôt que de montrer la série chronologique sur l’axe vertical, nous traçons l’évolution des gains réels de chaque groupe démographique de 1980 à 2016.

Près de la moitié des points sont inférieurs à zéro. Cela met en évidence la nature inégalitaire de la croissance économique. Autrement dit : environ la moitié des groupes démographiques n’ont pas vraiment bénéficié de la croissance spectaculaire de l’ère numérique. Plus intéressant encore, nous présentons sur l’axe horizontal notre mesure de l’automatisation, qui correspond essentiellement à la fraction des tâches qu’un groupe démographique avait l’habitude d’effectuer et qui ont été automatisées. Pour de nombreux groupes ayant un faible niveau d’éducation, tels que les diplômés de l’enseignement secondaire, en particulier les jeunes hommes, la majorité des emplois impliquaient des tâches manuelles dans des entreprises comme Ford ou General Motors. On constate au total que l’automatisation accentue les inégalités et qu’elle est responsable d’environ 60 à 70 % de l’évolution de l’inégalité salariale.

La manière dont nous utilisons et développons la technologie et la manière dont nous nous organisons autour d’elle relèvent donc, en grande partie, d’une série de décisions. C’est dans cet enchevêtrement que la compréhension du fonctionnement des institutions et du pouvoir devient essentielle. On peut à cet égard analyser deux tendances issues des grandes transformations qui se sont produites depuis les années 1980.

La première correspond à un changement qui peut paraître inévitable après coup mais qu’il ne faut pas sous-estimer : en quarante ans, le mouvement syndical aux États-Unis s’est considérablement affaibli. Certes, si on analyse le temps long, la désindustrialisation avait déjà entamé un processus d’affaiblissement des syndicats. Mais c’est bien une décision politique qui définitivement infléchi cette tendance. À l’été 1981, le président Ronald Reagan décide de licencier plus de 10 000 contrôleurs aériens en grève. De nombreuses autres entreprises suivent son exemple et adoptent une ligne beaucoup plus dure à l’égard des travailleurs, accélérant le déclin de la force syndicale aux États-Unis.

Une autre tendance semble tout aussi importante. Elle nous montre qu’il n’est pas suffisant d’étudier la technologie et le pouvoir : les idées et les normes qui justifient l’action des PDG, des chefs d’entreprise ou de certains hommes politiques particulièrement influents jouent un rôle non négligeable. En témoigne l’exemple d’Henry Ford et du modèle qu’il a développé, sans doute d’une manière involontaire, et qui a été appelé par des économistes institutionnels du début du XXe siècle le « capitalisme du bien-être » (welfare capitalism). Les entreprises obtiennent de bons résultats et partagent ensuite les gains avec leurs travailleurs ; elles partagent les gains parce que les syndicats les y obligent et parce que, en même temps, elles pensent que le partage des gains motivera les travailleurs.

Une idéologie alternative est apparue dans les années 1980. Comme beaucoup de révolutions idéologiques, elle ne peut pas être reconduite à une filiation linéaire. Mais la figure de Milton Friedman mérite toutefois d’être citée parce qu’il l’a beaucoup exprimée. Son texte le plus influent n’a pas été publié dans une revue scientifique mais dans le New York Times Magazine. Il y affirmait que la seule responsabilité sociale des entreprises était d’accroître la valeur actionnariale. Ce qui avait une conséquence évidente : les chefs d’entreprise devaient être encouragés à réduire le coût de la main-d’œuvre. L’idée était simple : pourquoi payer davantage sans y être obligés ? Cela impliquait plus d’argent pour les actionnaires et une volonté de réduire les coûts de la main-d’œuvre, qui est la composante la plus importante des coûts. La conséquence logique était, bien sûr, l’automatisation. C’est pourquoi l’on peut dire que l’idéologie de l’entreprise conduit mécaniquement à plus d’automatisation. Des syndicats forts auraient pu être un rempart contre cette tendance, mais ils étaient en déclin et ne pouvaient donc pas prétendre opposer une résistance suffisamment construite.

L’automatisation accentue les inégalités et qu’elle est responsable d’environ 60 à 70 % de l’évolution de l’inégalité salariale.

Daron Acemoğlu

Ces deux tendances se sont combinées en produisant une déferlante.

Il en existe une troisième qui n’est toutefois peut-être pas moins importante : vous pouvez automatiser autant que vous voulez sans rencontrer la moindre résistance, mais si vous ne disposez pas des outils techniques suffisants, vous n’aurez pas beaucoup de succès.

Or, en particulier à la fin des années 1970 et dans les années 1980, une industrie était prête à fournir ces outils. C’est en elle que l’on trouve la matrice d’un état d’esprit particulièrement diffus aujourd’hui. Pour comprendre l’IA — et plus généralement ce que le développement technologique du numérique est censé accomplir — on ne peut pas faire l’impasse sur ce point.

Pourquoi remplacer les humains

Pour le comprendre il faut remonter à la pensée d’Alan Turing, le pionnier de l’informatique contemporaine. Turing, qui était un mathématicien, a essayé de conceptualiser ce que les machines devraient faire, ce qu’elles peuvent faire, et comment leurs actes peuvent être comparés à ceux de l’esprit humain. Il est arrivé à la conclusion que les ordinateurs fonctionnaient ou auraient dû fonctionner comme l’esprit humain — ou peut-être même que l’esprit humain fonctionnait déjà comme les ordinateurs qu’il avait imaginés. Si l’on suit cette vision, il devient souhaitable que les ordinateurs, les outils numériques, dans leur développement, prennent en charge de plus en plus de tâches accomplies par les humains.

Turing pensait que le cerveau humain n’était au fond rien d’autre qu’une machine de Turing. Cette idée avait une conséquence : en fin de compte, si vous avez une machine de Turing universelle, c’est qu’elle peut accomplir toutes les tâches cognitives que le cerveau humain accomplit. Il paraît évident que c’est ce point de vue que la communauté qui travaille à l’IA a épousé sans broncher.

Le vénérable petit groupe de gentlemen qui a donné naissance au domaine de l’IA lors de la conférence de Dartmouth en 1956 embrassait cette perspective : pour eux, l’IA était la branche censée développer l’intelligence autonome des machines. Leur objectif était de développer des machines capables d’accomplir des tâches comme les humains, de manière autonome, c’est-à-dire sans intervention extérieure.

Cette idée puissante a deux conséquences. D’un côté, si les machines sont déjà capables de faire des choses comme les humains et qu’elles s’améliorent progressivement, alors il faut leur confier plus de tâches, en les retirant aux humains. De l’autre, cette tendance ne créera pas non plus un moteur naturel pour inciter les humains à accomplir de nouvelles tâches et à étendre les capacités et les actions humaines.

Le problème est que cette perspective, du moins avant l’ère de l’IA, n’a pas été couronnée de succès. L’ère de l’innovation est toujours à nos portes, sous l’impulsion des outils numériques, mais les gains de productivité ne sont jamais au rendez-vous. Si l’on considère la mesure de la productivité préférée des économistes — la croissance de la productivité globale des facteurs — l’ère numérique est beaucoup plus lente en termes de croissance de la productivité que les décennies précédentes. Ce phénomène ne se limite pas aux États-Unis mais se retrouve aussi dans d’autres pays industrialisés.

Nous choisissons chaque jour le type d’institutions dans lesquelles nous vivons.

Daron Acemoğlu

La surutilisation de l’automatisation est problématique en raison de ses effets distributifs : si on en abuse — en remplaçant des tâches accomplies par des humains par celles que peuvent accomplir les machines — on n’obtient pas de bénéfices en termes de productivité, produisant un type d’automatisation paresseuse qu’on pourrait appeler une « so-so automation » : bien sûr, à la fin, les entreprises gagneront quelques dollars de plus parce qu’elles économisent sur les coûts de main-d’œuvre, mais il n’y aura pas de révolution de la productivité sans amélioration de la qualité des produits — un peu comme un service client automatisé, ou des caisses automatiques qui ne fonctionnent pas.

L’IA va-t-elle changer cela ? Je ne le pense pas. C’est pour cela que parler des technologies numériques et de l’IA comme d’un simple phénomène économique ne suffit pas. Ce sont des outils d’information, ce qui signifie qu’ils influencent tous les aspects de notre vie sociale, y compris la participation démocratique et politique.

La surveillance n’est qu’un aspect de la manière dont l’IA et d’autres outils connexes, en particulier les outils de reconnaissance faciale, vont affecter le paysage politique. Le contexte est beaucoup plus large que cela, car il s’agit du contrôle de quelque chose de fondamental : l’information. Tout le monde, du moins en Occident, reconnaît la nature problématique du système de crédit social qui a déjà été mis en œuvre en Chine, où il faut aller vérifier ses points avant de pouvoir passer à la caisse et acheter un billet pour assister à un spectacle ou prendre un métro.

Mais ce que nous avons ici n’est pas franchement beaucoup mieux.

Au lieu de donner au Parti communiste le monopole sur le contrôle de l’information, nous laissons à des entreprises privées le soin de la collecter, traiter et contrôler. Si l’on suit le raisonnement — à savoir qu’il n’y a pas de chevauchement nécessaire, pas d’alignement complet entre les intérêts des entreprises et ceux des travailleurs et de la société dans son ensemble — pourquoi devraient-ils avoir recours à ce contrôle massif, profond de l’information ? C’est une question qui nécessite une discussion beaucoup plus large.

Comment bifurquer ?

On peut conclure toutefois avec quelque chose de légèrement plus encourageant. Après avoir souligné les problèmes liés aux changements de direction de l’innovation, nous ne voudrions pas donner l’impression qu’il s’agit d’un piège dont on ne pourrait s’échapper. Nous avons toujours la possibilité de faire des choix qui sont essentiels. Nous choisissons chaque jour le type d’institutions dans lesquelles nous vivons. Nous choisissons la direction de l’innovation — ou, du moins, nous avons notre mot à dire, en théorie, sur cette direction. Le problème actuel est que nous renonçons à ce choix et laissons le débat sur le futur de l’IA à quelques individus. La société, les travailleurs, les syndicats doivent participer au débat sur l’IA. Il s’agit là d’une question cruciale. Le capitalisme social n’est pas né tout seul. Il a été construit par les syndicats et les organisations intermédiaires de la société civile. Il est impossible de construire une prospérité partagée si tous les outils du numérique poussent à l’automatisation et à la centralisation de l’information entre les mains de quelques grandes entreprises.

Il y a un choix à faire. Il est très intéressant de constater qu’à chaque étape de la révolution numérique, des personnes, pas les moindres, pensaient qu’il était possible et probable que les outils numériques jouent un rôle décentralisateur et démocratisant.

Au début de l’ère de la diffusion massive de l’ordinateur personnel, un activiste politique et un technologue, Ted Nelson, considérait que les grandes entreprises étaient en train de tuer la technologie parce qu’elles l’exploitaient de la mauvaise manière. Il considérait qu’une autre voie était possible. Ted Nelson n’a jamais réalisé de percée technologique, mais plusieurs autres personnes l’ont fait et constituent, à mon avis, un bien meilleur modèle pour les types d’IA que nous voulons.

À l’époque où Alan Turing développait sa vision des ordinateurs et de leur avenir, un mathématicien et ingénieur de renom, Norbert Wiener, produisait une œuvre remarquable. Dès 1949, il s’inquiétait de l’automatisation du travail par les robots et des effets pour les travailleurs et pour les salaires. Dans son travail, Norbert Wiener a exposé une vision différente de ce que la technologie devrait faire. Nous pouvons la désigner par la notion de « l’utilité de la machine » (machine usefulness), pour l’opposer à l’intelligence de la machine. Les machines doivent être au service de l’homme et de l’action humaine. Norbert Wiener, qui était lui-même un ingénieur théoricien, n’a jamais proposé de technologies pour y parvenir, mais plusieurs autres personnes l’ont fait. Douglas Engelbart et ses étudiants, dans les années 1950 et 1960, ont réalisé de nombreuses avancées telles que l’invention de la souris, les ordinateurs à menu, les hyperliens, l’hypertexte… que nous considérons aujourd’hui comme allant de soi, parce qu’ils structurent notre monde. Ces outils ne sont pas le fruit d’une vision selon laquelle nous devrions tout automatiser à tout prix. Bien au contraire, ils montrent la possibilité d’une complémentarité homme-machine.

Les machines doivent être au service de l’homme et de l’action humaine.

Daron Acemoğlu

Joseph Carl Robnett Licklider, qui pourrait être considéré comme le père de l’internet parce qu’il en a conçu et soutenu le développement au sein de l’ARPA, avait exactement la même idée. Il en parlait avec une expression qu’il faut récupérer : la symbiose homme-machine (man machine symbiosis). Ce sont ces penseurs qui ont pensé une bifurcation. C’est en les suivant que nous pouvons développer les outils d’une manière qui permettrait aux humains d’en faire plus, pas moins.

L’IA, si elle était conçue sans se limiter à l’automatisation, pourrait aller dans ce sens. En tant qu’outil d’information, elle pourrait donner plus de capacités à de nombreuses personnes plutôt que de chercher à les remplacer.

Toutefois, ce n’est pas la direction que nous prenons. Comment faire pour dire quelque chose qui ne ressemble pas à un simple vœu pieux ? Je conçois que l’on puisse penser que tout se passe comme si je postulais que tous ces immenses génies de la Silicon Valley ne savaient pas ce qui est le mieux pour nous tous, pour la société et pour nos institutions et que nous, analystes qui restons à l’extérieur du développement, ne pouvons pas avoir une vision différente de ce qui est peut-être plus souhaitable… La réglementation gouvernementale et la pression sociétale pourraient changer la donne. De nombreux économistes diraient qu’il s’agit là d’un raisonnement fantaisiste, mais ce n’est pas aussi fantaisiste que l’on pourrait le croire.

Un exemple l’illustre très bien : le secteur de l’énergie. Pendant des décennies, nous avons construit, encore et encore, plus de technologies basées sur les combustibles fossiles. Les ingénieurs qui les ont mises en place n’ont pas tenu compte du fait que si les technologies liées aux combustibles fossiles étaient très rentables pour eux, elles n’étaient pas bonnes pour la société. Il a fallu des négociations, des réglementations, l’action de plusieurs gouvernements, des subventions pour l’innovation verte et la pression de la société pour changer la donne. À la fin des années 1990 et au début des années 2000, les énergies renouvelables étaient 20 fois plus chères pour produire de l’électricité. Mais nous avons bénéficié d’énormes progrès technologiques et d’un apprentissage par la pratique.

Aujourd’hui, elles sont moins chères que les combustibles fossiles pour produire de l’électricité.

Notre route n’est pas tracée. Nous pouvons encore bifurquer.

Sources

- Cet article est une transcription ajustée de la conférence inaugurale Albert Hirschman, lancée par le programme de gestion des transformations sociales de l’UNESCO le 8 octobre à l’UNESCO à Paris. La conférence Albert Hirschman représente une nouvelle modalité conçue pour promouvoir le dialogue sur les défis mondiaux urgents et pour catalyser l’exploration intellectuelle dans les sciences sociales pour les futures générations de chercheurs, de décideurs politiques, d’acteurs de la société civile et d’activistes. Grâce à cette conférence annuelle, l’UNESCO offre une plateforme à des intellectuels de haut niveau et à des chercheurs renommés de diverses disciplines pour discuter de questions mondiales dans un contexte interdisciplinaire.

- Folk Theorem. Nous reprenons la traduction de Bernard Guerrien utilisée par plusieurs théoriciens des jeux. L’expression désigne un théorème répandu sans qu’on puisse l’attribuer à un auteur en particulier. Elle est parfois également traduite par « théorème commun ». Voir Eulalia Damaso, « Le traducteur face à un domaine spécialisé », ASp, 11-14 | 1996, 181-193. (NdT)