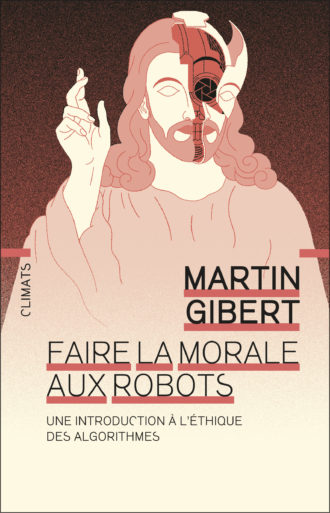

Faire la morale aux robots

« S’intéresser à l’éthique des algorithmes, c’est plonger au cœur de nos différentes intuitions et théories morales, questionner nos biais et préjugés, mais aussi explorer un nouveau domaine de la philosophie. » Nous publions l'introduction de l'ouvrage de Martin Gibert.

S’il y a un truc que je n’aime pas, ce sont bien les dilemmes de bus. Ça arrive sans prévenir : devrais-je avertir cet ado que l’étiquette de son pull est sortie ? Devrais-je laisser ma place à l’homme âgé ? Est-il assez vieux, va-t-il mal le prendre ? Ou à cette femme un peu ronde qui pourrait être enceinte – ou pas ? C’est ce genre de décisions délicates, parfois embarrassantes, entre éthique et politesse, qui nous rappellent à nos limites intellectuelles. On voudrait bien faire, mais on n’a pas toutes les informations, et on doit faire un choix.

Heureusement, en ce 1er juillet, la 55 qui remonte le boulevard Saint-Laurent, à Montréal, n’est pas trop achalandée. Je m’en vais voir mon amie Christiane. Tous les passagers sont assis. Je suis moi-même sur la gauche, côté rue, plutôt vers l’arrière, avec une bonne perspective sur cette microsociété.

Lorsque je suis monté, avenue du Mont-Royal, j’ai tout de suite été frappé par une variation inat tendue. Chaque semaine, je prends la 55 pour me rendre à l’Institut de valorisation des données, dans la nouvelle cité de l’intelligence artificielle (IA) – à côté de chez Christiane, en fait. Les passagers sont habituellement beaucoup plus jeunes, blancs et bar bus. Mais en cet après-midi de fête nationale du Canada, les étudiants en intelligence artificielle, les programmeurs de jeux vidéo et autres employés des entreprises de technologie sont restés chez eux. Je les imagine en short et fumant de l’herbe légale. Plusieurs jouent probablement à la console.

C’est une belle journée. On sent des effluves de bonne humeur et de confiance mutuelle planer sub tilement dans le bus. En face de moi, assise côté trottoir, il y a une vieille Asiatique enroulée sur sa canne. Elle se déplace avec difficulté – je la comprends de préférer les heures creuses de l’après-midi. Il y a aussi une jeune musulmane, à en juger par son foulard, avec un gros sac de nourriture. À ses côtés, une femme noire très belle ne perd pas du regard son enfant qui dort dans une poussette. Deux jeunes queers, cheveux rasés et anneaux dans le nez, complètent cet échantillon humain.

Dans la 55, tandis qu’on remonte la Main, je pense à mon livre. Comment programmer les robots de façon morale ? Voitures autonomes, assistants virtuels, algorithmes de recommandation, robots militaires ou artistes, robots de soin : je regarde les gens dans le bus et je me demande ce que le développement de l’intelligence artificielle changera à leur quotidien. J’entrevois aussi un problème difficile, mais pas insurmontable : comment programmer les robots en fonction de principes moraux qui puissent satisfaire tout le monde ?

C’est très certainement un avenir perfusé de sys tèmes d’intelligence artificielle qui nous attend. On ne pourra pas échapper à la question. Avec quelle sorte de robots voulons-nous vivre ?

Ce livre traite de l’éthique des algorithmes, c’est-à-dire de la bonne manière de programmer les machines ou les robots 1. On pourrait d’ailleurs dire éthique des machines ou éthique des robots, mais si je préfère parler d’éthique des algorithmes, c’est parce que cette expression met bien en évidence le rôle de la programmation.

Qu’est-ce qu’un algorithme ? Rien de plus qu’une suite d’instructions – ou de règles – pour parvenir à un objectif donné. Autrement dit, on utilise un algorithme aussi bien lorsqu’on suit une recette de houmous (faire cuire des pois chiches, les écraser, etc.) que lorsqu’on programme un logiciel de comptabilité ou un assistant virtuel comme Siri, d’Apple, ou Alexa, d’Amazon. La question posée par l’éthique des algorithmes, c’est donc celle de savoir quelles règles implanter dans les robots, et comment le faire.

Ce n’est pas la même chose que l’éthique de l’intelligence artificielle. Celle-ci correspond à la branche de l’éthique de la technologie qui évalue les systèmes d’IA et se demande s’ils sont bons pour nous. Faut-il développer des voitures auto nomes, des robots militaires ou des robots sexuels ? Faut-il accepter toute nouvelle techno logie sous prétexte qu’elle serait plus efficace ? Quelles conséquences sur notre vie privée, sur les relations humaines ou sur la crise climatique ? L’éthique de l’IA porte sur nos comportements et nos choix.

De son côté, l’éthique des algorithmes porte sur les « choix » des machines, lesquels sont bien sûr, avant tout, ceux des programmeurs. Quels principes moraux implanter dans les voitures auto nomes, les robots militaires ou les robots sexuels ? Si les choses sont compliquées, c’est parce que les robots sont en partie autonomes. Programmer une IA, c’est anticiper les situations auxquelles elle sera confrontée, prévoir la manière dont elle se comportera face à l’inconnu ou à l’inattendu. Mais si les choses sont compliquées, c’est surtout parce qu’on doit programmer les robots de façon morale, c’est-à-dire en fonction de certaines normes.

Les philosophes classent les normes selon diffé rentes catégories. Les normes conventionnelles dépendent de cadres spécifiques : elles donnent des raisons de faire quelque chose à ceux qui adhèrent à la convention. C’est le cas des règles qui permettent de jouer aux échecs, par exemple, tout autant que de celles qui dictent l’écriture d’une langue (orthographe, syntaxe). Les règles d’étiquette ou de politesse, comme la manière de se tenir à table ou dans le bus, sont aussi des normes conventionnelles.

Les normes prudentielles, de leur côté, sont des règles qui nous permettent de satisfaire nos préférences personnelles. Qu’on recherche l’amour, la richesse ou la santé, elles nous donnent des raisons d’agir selon notre intérêt propre.

Les normes morales se distinguent des normes prudentielles et conventionnelles parce qu’elles valent pour tout le monde. Ce sont des règles de conduite qui visent l’intérêt général, le bien ou la justice. Elles sont universelles au sens où elles ne favorisent aucun individu ni groupe en particulier, correspondant à ce que Peter Singer nomme le point de vue éthique. Celui-ci consiste à examiner une situation ou un problème non pas de son propre point de vue (prudentiel) ni de celui de son groupe (conventionnel), mais de façon neutre et équitable – un point de vue qui pourrait, en somme, être accepté par tous les passagers du bus. On le voit, ce n’est pas une mince affaire : quelles normes morales doit-on implanter dans les robots ?

*

Et tandis qu’un drôle de type monte dans la 55 en reprenant son souffle, je me rends compte que j’étais jusqu’à présent le seul homme à bord. Je réalise un truc. Il serait facile pour ceux qui réfléchissent à la bonne façon de programmer les robots de négliger les passagères des jours fériés. Je prends une note mentale : me souvenir de ne pas les oublier.