Le 7 août, OpenAI a lancé son dernier modèle d’IA, GPT-5. Beaucoup s’attendaient à un moment décisif pour l’entreprise dirigée par Sam Altman, mais aussi pour le développement de l’intelligence artificielle générale. Que s’est-il réellement passé ?

C’était censé être l’annonce qui allait asseoir la domination d’OpenAI.

Après des mois de rumeurs, GPT-5 était enfin là. Avant le lancement de la diffusion en direct, Sam Altman a publié une capture d’écran du film Rogue One, de la saga Star Wars, sur laquelle on voit l’Étoile de la mort se profiler à l’horizon.

Les attentes n’ont fait que croître. Dès l’ouverture du direct, Sam Altman, fidèle à lui-même, a déclaré : « Nous pensons que vous aimerez utiliser GPT-5 beaucoup plus que toute autre IA auparavant. Il est utile, intelligent, rapide et intuitif. GPT-3, c’était un peu comme parler à un lycéen : des éclairs de génie, mais aussi beaucoup d’agacement. GPT-4, c’était plutôt comme discuter avec un étudiant de l’université… Avec GPT-5, c’est désormais comme parler à un véritable expert, un expert de niveau doctorat dans n’importe quel domaine, capable de vous aider à atteindre vos objectifs. »

Mais la réalité a rattrapé la mise en scène.

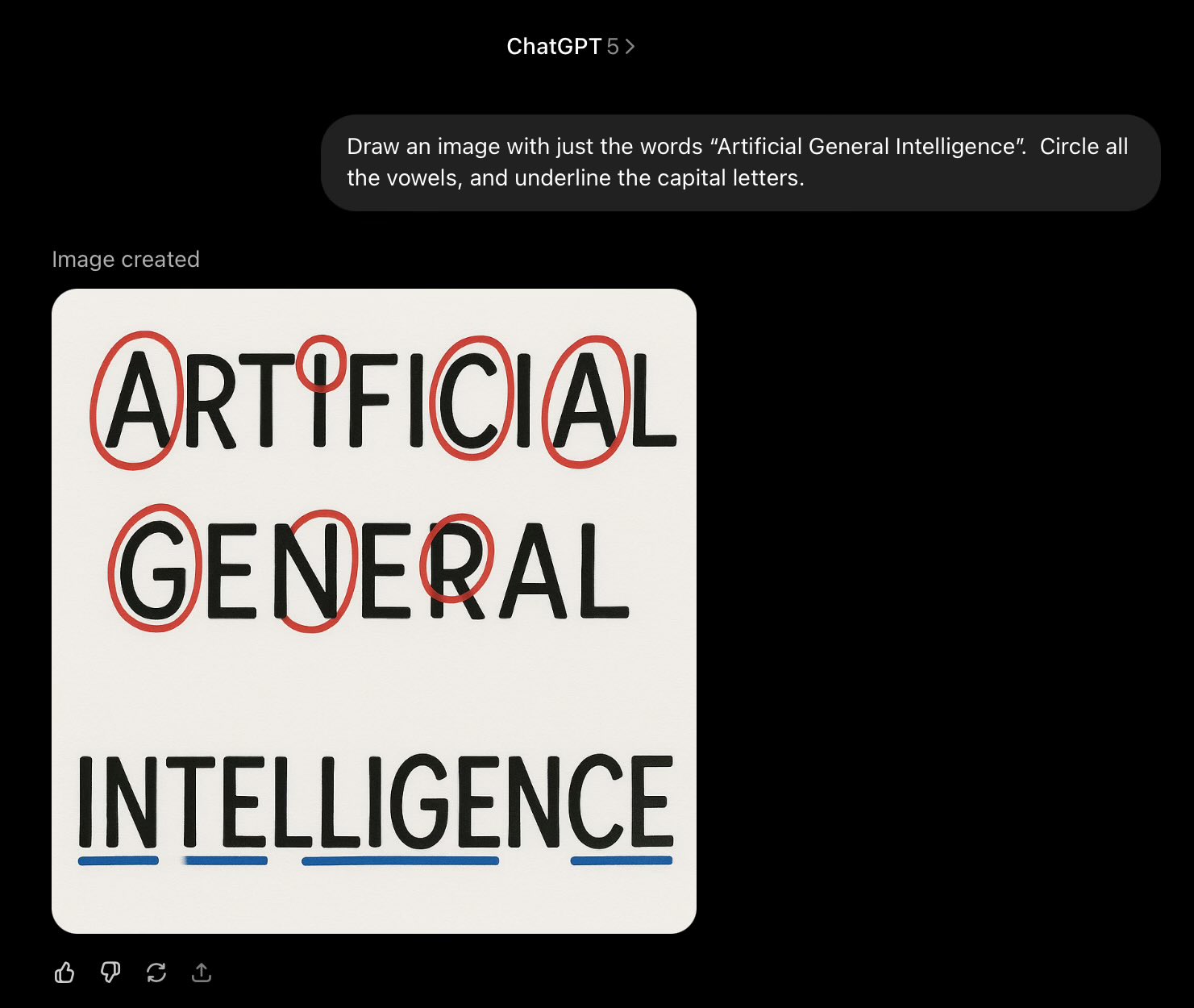

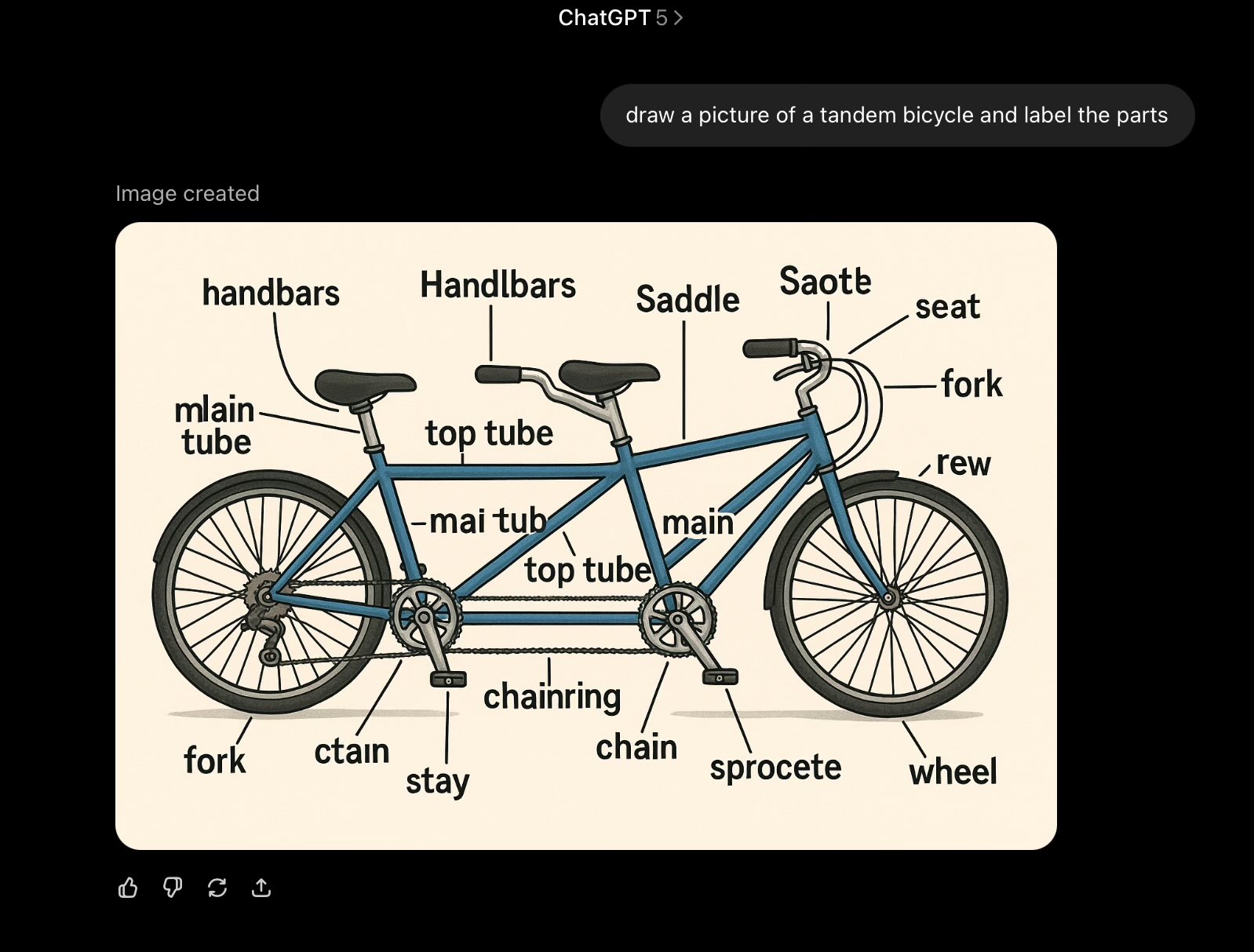

Les réactions ont été dominées par la critique. Il ne s’agissait pas de quelques erreurs isolées : comme pour les versions précédentes, GPT-5 fait des fautes absurdes, des hallucinations, et enregistre des performances médiocres sur certains benchmarks. Un nouveau mécanisme de « routage » automatique a été jugé confus. L’effet fut d’autant plus marqué que les attentes étaient élevées : alors que GPT-4 avait marqué un saut qualitatif par rapport à GPT-3, GPT-5 est apparu comme une grande déception.

Qu’est-ce qui fait que cette réaction est différente des précédents lancements ?

Pour GPT-3 et GPT-4, on pouvait encore parler d’avancées radicales. GPT-5, lui, n’est que marginalement meilleur que certains concurrents déjà sur le marché, et parfois même moins performant sur des tests comme l’ARC-AGI-2 1.

Ce n’est pas un mauvais modèle — mais ce n’est pas non plus la révolution annoncée.

Beaucoup s’attendaient à ce que GPT-5 soit une IA générale, ou du moins s’en approche. Le résultat : un choc de réalité.

Quelles sont les implications pour OpenAI ?

Elles sont considérables.

OpenAI n’a plus de véritable avance technique, et GPT-5 ne restera sans doute pas longtemps le modèle le plus performant. Plusieurs de leurs meilleurs talents ont quitté l’entreprise, souvent pour fonder des concurrents, tandis que des acteurs comme Elon Musk, Anthropic ou Google progressent rapidement. Les relations avec Microsoft sont devenues plus tendues, et l’entreprise, loin d’être rentable, a été contrainte de baisser ses prix.

Dans le même temps, l’idée que les LLM soient proches de l’AGI perd en crédibilité, et la confiance envers la compagnie et son PDG s’érode.

OpenAI conserve certes un nom connu et une interface utilisateur appréciée, mais cela suffira-t-il à soutenir une valorisation de plusieurs centaines de milliards de dollars ?

Rien n’est moins sûr. En toute logique, la réputation de Sam Altman devrait être sérieusement entachée.

Ses déclarations passées — affirmant savoir comment construire l’AGI ou comparant GPT-5 à un expert de niveau doctorat universel — apparaissent désormais comme des promesses intenables. Le contraste entre ces annonces et les réelles capacités du produit explique en grande partie l’ampleur de la déception.

Comment les autres modèles se positionnent par rapport à GPT-5 ?

Les autres grands modèles présentent les mêmes limites.

Un exemple particulièrement éclairant vient du psychologue Jonathan Shedler, auteur de l’un des articles les plus lus et les plus cités sur l’évaluation de l’efficacité des psychothérapies.

Lorsqu’il a interrogé Grok, sur ce même article, le résultat était entièrement faux : l’IA a inversé les conclusions en affirmant que la thérapie psychodynamique était moins efficace que la thérapie cognitivo-comportementale, alors que son article démontrait précisément l’inverse.

L’effet de la thérapie psychodynamique dans l’article était de 0,97. Grok affirme qu’il s’élève à 0,33. Ce chiffre n’apparaît pourtant nulle part dans l’article.

Ce type d’erreur illustre un problème structurel : ces systèmes donnent l’impression d’une maîtrise encyclopédique, mais s’effondrent lorsqu’ils sont confrontés à un domaine que l’on connaît réellement.

Où est-ce que cela nous laisse par rapport à l’IA générale ?

Les LLM restent incapables de généraliser largement lorsqu’on les confronte à des situations qui sortent du cadre de leurs données d’entraînement.

Une étude de l’université d’État de l’Arizona, parue le 5 août 2, vient de le confirmer, validant ainsi ce que je répète depuis près de trente ans, et plus récemment ce qu’Apple a exposé dans un article au mois de juin 3.

Dès 1998, j’avais déjà montré dans un article que les perceptrons multicouches (multilayer perceptrons), les ancêtres des modèles de langage actuels, ne parvenaient pas à appliquer de manière fiable des universaux linguistiques ou logiques en dehors du champ d’exemples appris. Les auteurs de cette étude montrent que cette limitation persiste aujourd’hui, malgré toutes les innovations apportées depuis.

C’est précisément cette incapacité à généraliser qui explique pourquoi toutes les tentatives de création d’un modèle de niveau GPT-5, qu’elles viennent d’OpenAI ou d’ailleurs, sont vouées à l’échec. Ce n’est pas un accident de parcours, mais une limite de principe. Autrement dit, tant que cette faiblesse structurelle n’est pas surmontée, les performances resteront bloquées, quelles que soient les ressources investies.

Cette impasse marque-t-elle la fin de l’approche actuelle ?

Je suis désolé de devoir le répéter, mais je vous l’avais déjà dit.

Personne dotée d’une intégrité intellectuelle ne devrait croire que le « pure scaling » — investir davantage d’argent et de puissance de calcul dans les LLM — nous mènera à l’AGI.

Après avoir investi plus de 500 milliards de dollars dans cette direction, le constat est clair : les limites qualitatives observées sur GPT-3 ou GPT-4 — hallucinations persistantes, erreurs de raisonnement, faiblesses en vision, difficultés à effectuer des tâches simples comme compter correctement — se retrouvent à l’identique dans GPT-5, malgré des gains marginaux et un coût moins élevé.

Le mythe d’une AGI imminente grâce au seul « scaling » doit être abandonné.

La fameuse formule selon laquelle « l’attention est tout ce dont on a besoin » 4, s’avère donc trompeuse. La seule voie réaliste vers une intelligence artificielle générale passe par des approches neurosymboliques intégrant des modèles explicites du monde, capables de raisonner sur des représentations durables, abstraites ou symboliques. Tant que nous ne disposerons pas de ce type de systèmes, nous ne pourrons pas franchir le seuil qualitatif qui nous sépare encore de l’AGI.

Sources

- ARC-AGI-2 est un benchmark conçu pour évaluer de manière fine les capacités d’un modèle sur des tâches de raisonnement abstraites « faciles pour les humains et difficiles pour l’IA ».

- Chengshuai Zhao, Zhen Tan, Pingchuan Ma, Dawei Li, Bohan Jiang, Yancheng Wang, Yingzhen Yang, Huan Liu, Is Chain-of-Thought Reasoning of LLMs a Mirage ? A Data Distribution Lens, Arizona State University, 5 août 2025.

- Parshin Shojaee, Iman Mirzadeh, Keivan Alizadeh, Maxwell Horton, Samy Bengio, Mehrdad Farajtabar, The Illusion of Thinking : Understanding the Strengths and Limitations of Reasoning Models via the Lens of Problem Complexity, juin 2025.

- Ashish Vaswani, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N. Gomez, Lukasz Kaiser, Illia Polosukhin, Attention Is All You Need, 4 décembre 2017.